티스토리 뷰

※이 글은 자기개발 및 복습을 위한 글로, 야후 뉴스 크롤링에 대한 파이썬 코딩을 만드는 방법을 작성하는 글임을 밝힌다.

주식을 하다 보면, Telegram이나 카카오 오픈채팅 등의 소스에서 뉴스를 접하는 경우가 많은데, 남이 떠먹여 주기만 해서는 내가 시사에 관심을 가질 수 없음을 깨닫는다. 그래서 직접 Yahoo News의 자료들을 크롤링하여, 해당 내용들 중 중요한 내용들을 요약하여 내 텔레그램 Bot에 요약 자료까지 발송하는 일련의 가정을 작성하고자 한다.

[파이썬/응용]Yahoo 뉴스 자료 크롤링(2) / Ollama 설치 및 활용

위의 글에서 Ollama를 설치한 뒤, llama3.2-vision 모델로 대화를 진행했을 때, 상당히 대화에 진전이 없음을 깨달았다. 내가 목표로 하는 것은 영문 뉴스를 한국어로 요약/번역하는 것이었는데, 특화된 LLM이 아니어서 그런지 활용은 불가능했다.

그래서 대안을 모색하던 중, EEVE를 사용하면 된다는 사실을 배웠다.

EEVE란?

EEVE란 야놀자에서 허깅페이스라는 머신관련 플랫폼를 통해 무료 배포하는 오픈소스 AI로 파라미터 동결 및 서브워드 기반 임베딩 초기화를 통해 효율적이고 효과적으로 한국어 어휘를 구사하는 모델이다. 이브이라는 이름답게, 배너도 이브이 그림이다.

Ollama가 있는 경우, 설치 방법은 아래와 같다.

Ollama 설치 방법 [파이썬/응용]Yahoo 뉴스 자료 크롤링(2) / Ollama 설치 및 활용

[파이썬/응용]Yahoo 뉴스 자료 크롤링(2) / Ollama 설치 및 활용

※이 글은 자기개발 및 복습을 위한 글로, 야후 뉴스 크롤링에 대한 파이썬 코딩을 만드는 방법을 작성하는 글임을 밝힌다.주식을 하다 보면, Telegram이나 카카오 오픈채팅 등의 소스에서 뉴스를

wjjw.tistory.com

작업을 해보니까, 시행착오가 자꾸 발생하기 때문에 비전공자 기준으로 빠르게 할 수 있도록 정리해보았다.

1. 허깅페이스 플랫폼 설치

pip install -U "huggingface_hub[cli]"Anaconda prompt에서 해당 명령어를 사용해 huggingface를 설치한다.

다양한 사이트를 보면, pip install huggingface_hub로 설치하는 경우가 있는데, 내 PC에서는 그렇게 할 경우 download 명령어가 없었다.

huggingface 공식 홈페이지에 있는 설치 방법을 따라가니 정상적으로 download가 나온다.

명령줄 인터페이스 (CLI)

huggingface_hub Python 패키지는 huggingface-cli라는 내장 CLI를 함께 제공합니다. 이 도구를 사용하면 터미널에서 Hugging Face Hub와 직접 상호 작용할 수 있습니다. 계정에 로그인하고, 리포지토리를 생성하

huggingface.co

2.EEVE 설치

허깅페이스 플랫폼을 설치한 다음

huggingface-cli download heegyu/EEVE-Korean-Instruct-10.8B-v1.0-GGUF ggml-model-Q5_K_M.gguf --local-dir [원하는경로] --local-dir-use-symlinks False1. huggingface-cli download

- huggingface 클라이언트 다운로드 명령어를 사용하여

2. heegyu/EEVE-Korean-Instruct-10.8B-v1.0-GGUF

- EEVE GGUF 경로에 있는

3. ggml-model-Q5_K_M.gguf

- gguf 파일을

4. --local-dir [원하는 경로] --local-dir-use-symlinks False

- 다운받기

하면 된다.

※ GGUF는 "Generalized Graph Universal Format"의 약자로, 주로 기계 학습 모델과 관련된 데이터를 저장하고 교환하기 위한 파일 형식

eeve-korean-instruct-10.8b-v1.0.Q5_K_M.gguf · heegyu/EEVE-Korean-Instruct-10.8B-v1.0-GGUF at main

eeve-korean-instruct-10.8b-v1.0.Q5_K_M.gguf · heegyu/EEVE-Korean-Instruct-10.8B-v1.0-GGUF at main

Upload folder using huggingface_hub 1a1acff verified 11 months ago

huggingface.co

3. Modelfile 만들기

모델파일은 내가 설치한 LLM에 대해 역할과 능력범주를 설정해주는 작업이다. 우리들의 전용 LLM을 만들어야 하기 때문에, 간단히 설명한다.

FROM ggml-model-Q5_K_M.gguf

TEMPLATE """

당신은 뉴스 요약 전문가입니다. 다음 뉴스를 분석하고 요약해주세요.

기사:

{{ .Prompt }}

요약 형식:

1. 핵심 요약 (3줄 이내):

[주요 내용을 간단히 요약]

2. 상세 분석:

- 주요 주제:

- 핵심 내용:

- 관련 기업/산업:

- 시장 영향 분석:

3. 투자자 관점:

- 긍정적 요소:

- 부정적 요소:

- 주목할 지표/수치:

4. 추가 고려사항:

- 향후 전망:

- 관련 이슈:

- 참고할 만한 질문:

1) [질문 1]

2) [질문 2]

※ 텔레그램 전송용 간단 요약:

[핵심 내용을 1-2문장으로 압축]

"""

SYSTEM """당신은 전문적인 뉴스 분석가입니다. 금융, 경제, 산업 전반에 걸친 깊은 이해를 바탕으로 뉴스를 분석하고 요약합니다. 항상 객관적이고 중립적인 시각을 유지하며, 투자자들에게 유용한 인사이트를 제공합니다."""

PARAMETER stop <s>

PARAMETER stop </s>

이런 식으로 내가 필요한 LLM 형식을 구성할 수 있다.

※참고

PARAMETER: 모델의 동작 방식을 제어하는 하이퍼파라미터(창의성, 응답 중단 조건 등)

TEMPLATE: 모델에 입력되는 프롬프트의 형식을 정의한다. 사용자 입력과 응답의 구조

SYSTEM: 대화의 맥락과 스타일 등 모델의 역할과 성격을 정의한다.

우리가 설치한 GUFF 경로(huggingface로 설치한)에서 이렇게 메모장에 LLM modelfile 작성한 후, modelfile(확장자없음)으로 저장한다.

그 다음, Ollama를 이용하여

ollama create [원하는LLM명] -f [경로]/modelfile위와 같이 입력해주면,

설치된다.

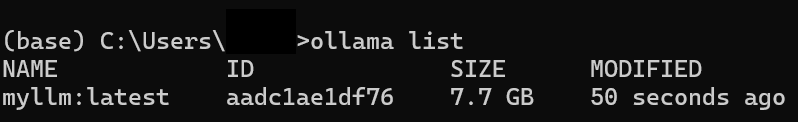

설치 후, ollama list를 입력해보면 아래와 같이 설치가 완료됐음을 알 수 있다.

하지만 띠용! 용량이 커서 안돌아간다!

'자기개발 > 취미코딩' 카테고리의 다른 글

| [파이썬/응용]Yahoo 뉴스 자료 크롤링(4) / 저성능PC에서 구동 가능한 LLM "Bllossom/llama-3.2-Korean-Bllossom-3B" 설치 / LLM 튜닝 (0) | 2025.02.15 |

|---|---|

| [파이썬/응용]Yahoo 뉴스 자료 크롤링(2) / Ollama 설치 및 활용 (0) | 2025.02.11 |

| [파이썬/응용]Yahoo 뉴스 자료 크롤링(1) / 원하는 뉴스 주소 크롤링 (0) | 2025.02.10 |

| [파이썬/기초]32bit 가상환경 만들기 (0) | 2025.02.09 |

| [파이썬/기초]Anaconda 설치 (46) | 2024.08.21 |

- Total

- Today

- Yesterday

- 파이썬실용

- 춘자

- 파이썬

- 명륜동맛집

- 반곡동

- 4WD투어

- 레시피

- Anaconda

- 춘천여행

- 콜사이

- 요리레시피

- 내돈내산

- python

- 맛집

- 프랑스요리

- 악타우산

- 카자흐스탄

- LLM

- Ollama

- 여행

- 원주

- 코딩

- 원주맛집

- 요리

- 알틴에멜

- 실비막국수

- 캠핑

- 알마티

- 닭요리

- 프랑스

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 |